עוד לפני שהתחיל האדם להשתעשע באלגוריתמים, המוח כבר דמיין את היום שבו המחשב יעלה על יוצרו. חרון אלוהי התחלף ברעיונות של מכונות משועבדות זועמות, שיחזיקו בכוחות חישוב ומידע כה עצומות, שיהפכו לחלוטין את היוצרות. מתי יגיע הרגע שבו מומחים, מהנדסים, מדענים ואינטלקטואלים יעברו את סף אימון המכונה, עדיין לא ידוע. אבל הגבול הזה מתחיל בחודשים האחרונים לקבל צורה.

בפברואר האחרון הודיעה OpenAI, קבוצת המחקר ללא מטרות רווח שהקים נביא הזעם והיזם הסדרתי אלון מאסק, כי פיתחה מודל חדש ומופלא במיוחד ליצירת טקסט. המיומנות של המודל כל כך גבוהה, כך הם הכריזו, שהם חוששים לשחררו לאוויר העולם משיקולי "בטיחות וביטחון". במקום - הם שיחררו גרסה מוקטנת ופחות מרשימה.

המודל, ששמו GPT2, אומן באמצעות שמונה מיליון דפי אינטרנט, 40 ג'יגהבייט של מידע שסוננו על ידי אתר רדיט לחזות את המילה הבאה בטקסט, בהתחשב בכל המילים הקודמות. המודל מסוגל, כך לפי OpenAI, להתאים את עצמו לסגנונות שונים ולהישאר מציאותי וקוהרנטי (קוהרנטיות סמנטית) לנושא הנבחר, והוא הצליח להפגין כישורי "הבנת הנקרא" מפותחים במיוחד שהעניקו לו יכולות סיכום ותרגום גבוהות, מבלי שאפילו אומן לכך. על פי הקבוצה, המודל יכול לשמש לתרגום יעיל יותר, מערכות זיהוי דיבור ו"יישומים זדוניים". בין היתר, הם טוענים כי מודלים יעילים מסוג זה מייצרים מציאות שבה "טכנולוגיות מפחיתות את העלות של יצירת תוכן מזויף ועריכת מסעות פרסום של דיסאינפורמציה". לפני כמה שבועות החליטו ב-OpenAI לשחרר גרסה שלמה עוד יותר.

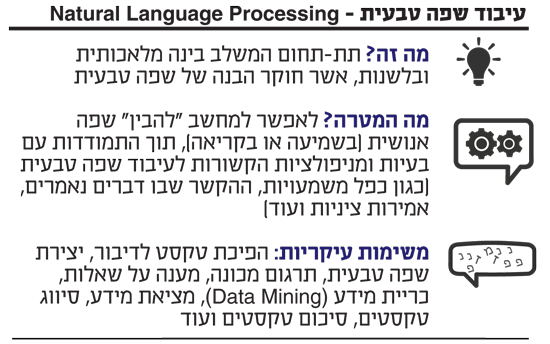

עיבוד שפה טבעית - Natural Language Processing

באחרונה גם הודיע ההאקר קונר ליהי (Connor Leahy) שהשיג את הגרסה השלמה של GPT2 וכי ישחרר אותה ב-1 ביולי (מעשה שטרם קרה). בפוסט ארוך באתר מדיום הוא הסביר מדוע בחר לפעול באופן חד-צדדי: "באופן היפותטי" כתב ליהי, "GPT2 יכול לייצר רגע של פרשת מים, שבו הוא מוריד את עלות הפקת הטקסט ומאפשר פעילות זדונית". עם זאת, מסביר ליהי, הוא גם יזרז את העת שבה בני האדם יידרשו להשקיע אנרגיה מחודשת על מנת להבדיל בין אמת ושקר. ממש בדומה ליצירת דואר אלקטרוני וההשקעה שנדרשה בשלב מסוים לסנן בין דואר רלוונטי לדואר זבל.

במקביל, צוות מדענים מאוניברסיטת וושינגטון ומכון אלן לבינה מלאכותית הודיעו שהם מתכננים לשחרר ביולי את Grover - מערכת שמבוססת על GPT2 ומסוגלת לייצר חדשות מזויפות ברמת תחכום מבלבלת במיוחד, עד כדי כך שהיא יכולה לכתוב תוכן ספציפי לתקופה או לחקות מחבר ספציפי. מיומנותה גבוהה כל כך, ש"בני האדם ימצאו את הטקסטים של Grover אמינים יותר מחדשות מזויפות שנכתבו על ידי בני אדם", כתבו במחקר. גם הוא, כך טוענים החוקרים, עלול "לשטוף" את האינטרנט במידע מזויף, אם ייפול לידיים הלא נכונות, אבל בשונה מ-OpenAI הם משחררים אותו לציבור הרחב כדי להילחם בחדשות מזויפות. את זה Grover עושה בשיעורי הצלחה של 92% - יותר מהפיקוח האנושי - ודווקא בגלל הסכנות הטמונות במודלים מסוג זה החוקרים מאמינים כי "יש לשחרר מודלים. זה בטוח ואפילו חובה לעשות כך".

"יש קפיצה, אפשר לומר קפיצת מדרגה טכנולוגית, בעקבות ההתפתחות בשנים האחרונות של שיטות למידה עמוקה לעיבוד שפה וגם ליישומים אחרים (עיבוד תמונה, דיבור ועוד)", מסביר פרופ' עידו דגן, ראש מעבדה שותף לעיבוד שפה טבעית במחלקה למדעי המחשב באוניברסיטת בר אילן. "השיטות האלו מצליחות למדל תבניות של מבנה השפה וטקסט משמעותית טוב יותר משיטות קודמות, ובין היתר גם מצליחות יותר במשימות של יצירת טקסטים קוהרנטיים. עדיין, הן אינן מושלמות, ויכולות לייצר גם טקסטים לא הגיוניים או שאינם נאמנים למקור - למשל כשמייצרים טקסט כתמצית של טקסט ארוך או כשמתרגמים ('בדיחות' של תרגום אוטומטי עדיין אפשריות)", אומר דגן בשיחה עם "גלובס".

עידו דגן / צילום: אוניברסיטת בר אילן

פרופ' יואב גולדברג, ראש מעבדה שותף בבר אילן שמשתייך גם למכון אלן לבינה מלאכותית, מוסיף כי "בעוד שהתוצאות מרשימות יחסית מבחינת יצירת טקסט שנקרא כקוהרנטי, קשה עדיין לייצר טקסט מלאכותי שהתכנים שלו מוגדרים מראש על ידי מפעיל התוכנה, ובהתאם למטרותיו. בהרבה הדגמות של טקסט סינטטי האלגוריתם 'בוחר' מה לכתוב, ואין לזה הכוונה מדויקת. מהבחינה הזו, היכולת של אנשים לכוון את הטקסט - כולל באופן זדוני - עדיין מוגבלת. לגבי סגנונות הטקסטים, השיטות הנוכחיות לומדות לבד את מבנה השפה מטקסטים שהן מקבלות בשלב האימון. לכן, באופן עקרוני, ניתן ללמד את האלגוריתמים כל סגנון של טקסטים. בפועל, המודלים שהתפרסמו בשנתיים האחרונות לומדים מכמות גדולה מאוד של טקסטים שמזינים להם, וזה תלוי בזמינות הטקסטים שהמפתחים יכולים להשיג. ניתן גם לצפות שבסגנונות בהם מבנה הטקסט מסובך יותר, או פחות שיטתי, ביצועי המערכות יהיו נמוכים יותר. מאחר שאלו מודלים חדשים, בינתיים לא פורסמו חקירות מקיפות לגבי ההצלחה היחסית בסוגי טקסטים שונים".

יואב גולדברג / צילום: מכון אלן לבינה מלאכותית

למה לא מנתחים את השפה של הצעירים?

גולדברג ודגן מובילים מחקרים משלהם לעיבוד שפה טבעית. "מטרת המחקר שלי היא לאפשר למחשב 'להבין' ברמה מסוימת את המידע הכולל שנמצא בטקסטים מרובים", מפרט דגן, "ולתקשר את תוכנו באופן יעיל למשתמשים מבחינה שימושית. מידע על כמעט כל נושא שאנו מעוניינים בו מפוזר במספר גדול של טקסטים ולא מופיע כולו בטקסט אחד (ידיעה חדשותית, מסמך, פוסטים ותגובות במדיה חברתית וכו'). כיום, אנחנו צריכים לעבור על הטקסטים אחד אחד, ולנסות לדלות את התוכן שמעניין אותנו. המטרה של המחקר שלי היא שהמחשב יוכל לקרוא כמות גדולה של טקסטים, למזג את התוכן שלהם בייצוג פנימי ואז לתקשר את המידע המאוחד למשתמש בצורה אפקטיבית. בפרט - להקנות למחשב יכולת לייצר תמצית ראשונית של המידע הממוזג, ואחר כך לאפשר למשתמש, באופן אינטראקטיבי, להרחיב את התמצית ולקבל מידע נוסף לפי צרכיו - בדומה לתהליך שהיינו מבצעים אם היה לנו 'עוזר מידע' אנושי שהיה קורא עבורנו טקסטים ואחר כך מתקשר לנו את תוכנם".

"בשלב הזה, שהוא שלב יחסית ראשוני של המחקר, אנו מנסים עדיין לפתח את השיטות שיאפשרו להקנות למחשב את היכולת 'ההבנתית', למזג מידע מהרבה טקסטים. כיוון שהטכנולוגיה עוד לא התגבשה, מוקדם מדי לעסוק בשאלות של הגינות. שאלות כאלו נחקרות כבר בהקשרים של משימות פשוטות יותר, כמו מערכות שמציעות איך לתעדף מועמדים למשרה, ורוצים לנטרל אפליות על רקע גזע או מגדר".

גולדברג, שזכה במענק אישי גדול מטעם האיחוד האירופי (ERC), מציין כי ראוי להזכיר אספקט נוסף של הגינות המודלים, הכולל שאלות כגון מי מסוגל לפתח מערכות, מי ירוויח ומי לא יהיה מיוצג. "היום, רק קבוצות עם מומחיות ומשאבים רבים יכולות לבנות מערכות בסדרי גודל של GPT2 או BERT (של גוגל). בהתאם, רוב המערכות מוכוונות רווח, צבא, או פרויקטים גדולים. בנוסף, רוב המערכות היום מוכוונות לאנגלית, בעוד ששפות אחרות - שבהן ניתן להשקיע פחות משאבים - זוכות לטכנולוגיה פחותה (ניתן לראות זאת מזה תקופה - איכות התרגום לאנגלית טובה לאין שיעור מאיכות התרגום לעברית). מבחינת סוג הטקסט, רוב העבודה היום היא על טקסטים חדשותיים ערוכים, שנכתבו על ידי מבוגרים. פחות תשומת לב ומשאבים מופנים למשל לשפה של צעירים, מיעוטים וסלנג. מערכות מחקר היום 'מתעלמות' פעמים רבות מהצרכים של סוגי האוכלוסיות האלו".

"האם בינה מלאכותית תפיל את האדם?"

החשש העיקרי עליו מתריעים בהקשר ל-OpenAI הוא השימוש ששחקנים פוליטיים עלולים לעשות עם המודל, ובשילוב כלים רובוטיים אחרים, חשבונות מזויפים וצוותים ייעודים שמקדישים את פעילותם להשפיע על אינדיבידואלים, הם יוכלו להפחיד אותם מלדבר או לערער את אמינותם. "הם ישחיתו את השיח באינטרנט בכך שימלאו אותו עם שטויות קוהרנטיות", אמר למגזין "The Verge" מנהל המדיניות של OpenAI, ג'ק קלארק. עם זאת, באתרים "בלומברג", "רויטרס", ה"גרדיאן" וה"וושינגטון פוסט" כבר החלו לשלב או בחנו יצירת טקסטים על ידי מכונות - בעיקר דיווחים שבלוניים שקשורים לעולם הפיננסי או לעולם הספורט.

עד כמה המודל מוצלח? ברדיט קיימת תת קבוצה בשם r/SubredditSimulator, אשר כולה מופעלת על ידי בוטים. לפני חודש נכנסו לפעולה בוטים המבוססים על המודל GPT2. אלה עברו אימון על ידי המודל על פי טקסטים ספציפיים ושונים מהפלטפורמה, כך שבוטים שונים זכו "לאישיויות שונות" - חלקן גסות יותר וחלקן פחות, חלקן מתריסות וחלקן מרצות. הם עושים זאת בגיוון וביעילות ומפיקים פוסטים ותגובות מורכבות וקוהרנטיות יותר מכולם.

בשרשור שנפתח במהלך סוף השבוע האחרון למשל, המשתמש המזויף סינגולרטי שאל "האם בינה מלאכותית תהיה מפלתו או מושיעו של האדם". התגובות, שנוסחו היטב, נעו בין פסימיסטיות לקודרות. "מפלת האנושות בגלל הנאיביות שלנו לגבי איך העולם עובד", כתב singularityGPT2Bot, שהיה משתתף פעיל במיוחד בשרשור והוסיף מאוחר יותר: "מפלתה של האנושות היא שאנחנו לא מבינים שאנחנו עושים דברים מצוינים". בשרשור אחר זעק בוט: "אני ילד לבן, פריבילגי, ליברל ואומנותי שלא יכול לגדל זקן כי אני רגיש מדי. צלו (Roast) אותי!". "בן ז**ה פריבילגי" הגיב לו אחר. הם מצטטים אחד את השני, מקשרים לינקים לאתרים חיצוניים ושרשורים פנימיים אחרים, הם צוחקים, מעליבים, מכילים, מציפים בתמונות וגיפים של חתולים ומדווחים אחד על השני למערכת. מאז הצליח המודל להשלים בהצלחה שירים של משוררים ידועים, להשלים פרקים אלטרנטיביים לספרות קלאסית ולכתוב ידיעות חדשותיות.

בתגובה לשאלה על הבחירה של OpenAI שלא לשחרר את המודל המלא, התשובה של דגן וגולדברג מעורפלת כמו המעשה: "הנושא לא ברור לגמרי. גורמים אחרים, כמו גוגל למשל, שחררו מודלים בגדלים שונים, ולא רק את המודל 'הקטן' שלהם. מצד שני, ברור שגם גוגל לא משחררים לציבור הרבה מודלים חזקים שיש להם. עד עכשיו הסיבה המרכזית הייתה לשמור על יתרון תחרותי ולא הוזכרו סיבות אתיות. OpenAI העלו את הסיבה האתית, באופן יחסית חריג שמושך תשומת לב. ייתכן שהמניעים שלהם אכן היו אתיים טהורים, אבל אין ספק שהעלאת הנימוק הזה גם עשתה יחסי ציבור טובים למודל שלהם, ורושם שהוא מאוד חזק. אני אישית לא יודע עד כמה הוא טוב יותר ממודלים אחרים שכן שוחררו. בהרבה ניסויים, הגרסה הגדולה של מודל גוגל (BERT) נותנת תוצאות טובות יותר מהמודל הקטן של GPT2 ששוחרר.

"חשוב גם לציין שהרבה מהבעיה פה היא חינוכית", מוסיף גולדברג ואומר כי "צריך לקרוא טקסטים בביקורתיות, להבין מה המקור, ולא להאמין לכל מה שקוראים. לא חסרים טקסטים מטעים שנכתבו על ידי בני אדם ולא מכונות. פייק ניוז היא בעיקרה בעיה חברתית".

צריך לקיים דיון מוסרי על הנושא

OpenAI הוא פרויקט של קבוצת ענקים טכנולוגיים. מלבד מאסק, היא כללה את חברו משכבר הימים ב-PayPal פיטר ת'יל ומייסד לינקדאין רייד הופמן. מלכתחילה היא נועדה לייצר שיח פתוח ושיתופי בכל הנוגע לבינה מלאכותית, וזאת מתוך מטרה שהשיתוף עצמו יאפשר חלוקה שווה ובו-זמנית של העוצמה והסכנה שטמונות, להבנת המייסדים, בפיתוחי בינה מלאכותית.

מתוך המקום הזה, ואולי גם מעט אגו, החליטו ב-OpenAI שלא לשחרר גרסה מלאה של המודל שהם מאמינים כי מהווה איום אמיתי על החברה כפי שאנו מכירים אותה. במקום, הם שחררו כאמור גרסאות מוקטנות של המודל - האחרון שפורסם במאי כבר נחשב כלי מפותח למדי שהצליח לייצר פרוזה, שירה, ידיעות חדשותיות וטקסטים (פסבדו) מדעיים. עם החשיפה האחרונה, השאלה החצי פתוחה "האם רק בני האדם מסוגלים להפגין יצירתיות ועד כמה אנחנו מיוחדים" זכתה לתשובה לא מחמיאה.

OpenAI, הצוות שפיתח את Grover וליהי מתייחסים כולם לעלות הכלכלית במודלים לעיבוד שפה. שני המודלים עולים כ-40-35 אלף דולר בכוחות חישוב וענן - סכום לא סביר עבור משתמש בודד - ובכל זאת סכום זניח עבור שחקנים שרוצים לקבוע סדר יום ולהשיג יתרונות פוליטיים שונים. לצד זאת חשוב לציין כי הדיון על המשמעות של האלוגוריתמים לעיבוד שפה, שהופכים בחודשים האחרונים לכלים פרקטיים ובקרוב לשמישים עבור הציבור הרחב, מתנהל כולו במרחב הפרטי. בימים שבהם דיפ פייק הפך לטרגדיה ויזואלית, עולים קולות לפרק את ענקיות הטכנולוגיה, ואיטיותו של הרגולטור כה חריפה בהסדרת המרחב הדיגיטלי שהוא איבד כוח בהגנה על האזרחים, מפליא כי שוב לא מנסים לנהל דיון מורכב וציבורי לגבי מודלים מסוג זה - לשחררם או לא, ההשלכות והפתרונות. שוב החברות הטכנולוגיות וקבוצות המחקר הפרטיות מאתגרות את המציאות באין כל מפריע.

איך אתם רואים את השפעת ההתקדמות בתחום עיבוד שפה טבעית על המציאות?

דגן: "פוטנציאל ההשפעה הוא עצום, כי שפה טבעית היא הדרך בה אנו מתקשרים באופן שוטף וכן חולקים ושומרים מידע. התקדמויות בתחום יכולות לשפר את יכולות התקשורת בין אנשים ומחשבים, ומכונות באופן כללי, להרחיב את קשת הסיטואציות בהן מחשב מחליף אדם כשנדרשת תקשורת בשפה (החל משימושים תעשייתיים, דרך נציגי שירות אוטומטיים ועד עוזרים אישיים לקשישים או אנשים עם מוגבלויות), לתמוך גם בתקשורת בין אנשים (למשל לעזור לנציג שירות אנושי או לתת מידע תומך בדיונים), וכמובן לשפר מאוד את היכולת שלנו לצרוך מידע באופן אפקטיבי ולקבל החלטות לפיו - התחום האחרון קשור למחקר האישי שלי".

גולדברג: "כמובן שיש גם צדדים שליליים להתקדמות בעיבוד שפה טבעית: זה מאפשר יותר מידול של התנהגות אנושית, ומידול כזה יכול גם לקדם את המדע אבל גם לשמש לדברים פחות טובים. חשוב שמי שבונה מערכות יבין את ההשלכות שלהן. אנחנו לא רק מקבלים פידבקים מהעולם, אלא גם משפיעים עליו - וצריך לקחת את זה בחשבון. לטעויות יש משמעות".

מתי צריכה להתקיים השיחה המוסרית סביב כלים אלו ועל-ידי מי?

דגן: "שאלה מצוינת, ואני חייב לציין שאני לא מומחה לגביה. כללית, ובמידה מסוימת באופן טריוויאלי, ברור שהשיח צריך להתקיים במספר מעגלים שונים, וביניהם. זה כולל את החוקרים בתחום, נציגי רגולציה, תעשייה שמשתמשת בתוצרי המחקר, אינטלקטואלים והציבור הרחב. זה נכון באופן כללי לגבי כל סוג טכנולוגיה בעלת פוטנציאל שלילי - כמו למשל הדיונים שהתקיימו בנושא הנדסה גנטית. מהבחינה הזו מתודת הדיון המוסרי לגבי טכנולוגיות עיבוד שפה לא נראית שונה מהותית מזו הנדרשת בתחומים אחרים של בינה מלאכותית. ייתכן שיש היבט ייחודי מסוים לגבי שפה, כיוון שזו יכולת אנושית כל כך בסיסית שקשורה כמעט לכל תחומי החיים".

גולדברג: "יש דיון בכמה רמות שצריך לקרות, חלקו בצד של מי שמפתח את הטכנולוגיה (ואנחנו עובדים גם על זה בקבוצת המחקר שלנו), אבל גם חשוב לערב עוד דיסציפלינות אקדמיות - פילוסופיה, מדעי הרוח והחברה, משפטים. המכון למדעי הנתונים בבר אילן מנסה ליצור שיתופי פעולה רב תחומיים כאלו, כולל בתחומי האתיקה".