חוקרים ביקשו מדמויות שנוצרו ב-ChatGPT לעשות מסיבה. איך זה נגמר?

בחזית ה-AI / צילום: Shutterstock

ד"ר קרן צוריאל-הררי היא חוקרת לא-מצביעים, תקשורת ואמון, עיתונאית לשעבר ובן אדם סקרן באופן כללי

אודות הפרויקט "בחזית ה-AI"

כולם מדברים על בינה מלאכותית, אבל כמה מאתנו באמת אימצו אותה לחייהם? בשבועות האחרונים יצאנו למסע בין כמה מהמוחות החריפים והמובילים בתחום, וביקשנו מהם לסייע לנו להרים את מכסה המנוע של הטכנולוגיה המהפכנית.

אנחנו שמחים להגיש לכם מסע בן עשרה פרקים אל רזי ה-AI, שבו נחקור את התופעה ובעיקר נמפה את ההיבטים היישומיים שלה. בכל שבוע נביא לכם פרק שעומד בפני עצמו, אך יש משמעות גדולה גם לאפקט המצטבר. בואו, יוצאים לדרך.

אמ;לק

חוקרים מהמחלקה למדעי המחשב באוניברסיטת סטנפורד בנו עולם שהדמויות בו מבוססות ChatGPT. כל אחת מהן נוצרה באמצעות פרומפט שהציג מי היא, מה היא עושה בחיים, עם מי היא גרה וכדומה. אז מה קרה לאחר שהחוקרים שתלו ב"ראשה" של אחת הדמויות את הרעיון לעשות מסיבה, ואיך הן התנהגו כשנודע להן שיש בקרוב בחירות לראשות העיר? מה שבטוח, "שום דבר ממה שהן עשו לא היה מקודד מראש".

איזבלה רודריגז החליטה לערוך מסיבת ולנטיין בקפה הובס שבו היא עובדת, ב־14 בפברואר בשעות 19:00-17:00. היא הזמינה כמה חברים וחלקם, כמו סם, הזמינו עוד חברים. מריה, שמאוהבת בקלאוס, הזמינה אותו להיות הדייט שלה. ביום המסיבה איזבלה קישטה את הקפה, ומריה, שהיא לקוחה קבועה וחברה טובה, באה לעזור. בשעה 17:00 חמישה חברים נוספים הצטרפו למסיבה, שהייתה מוצלחת.

עוד בסדרהלכל הכתבות

- החוקר שחושף: "זה מה שהביא להתפוצצות שאנחנו חווים עכשיו"

- יש לו קהילה עם 60 אלף חברים, והוא בטוח: זה סוף עידן הבינוניות

- האמנים שיצאו לקרב נגד הטכנולוגיה שבחזית

- איך הבינה המלאכותית עובדת? גם המדענים לא תמיד יודעים

- AI בעיני הון סיכון: איפה לשים את הכסף?

- בבית מדפיסים בתלת־ממד. אז למה בביה"ס חוזרים 200 שנה אחורה?

- מלוחמה פסיכולוגית ועד החלטה שהאנושות מפריעה לה: סכנות ה-AI

- "תעשיית ה-AI בישראל לא מודעת לגודל אירוע הרגולציה שמתקרב"

המסיבה הזאת לא התרחשה במציאות. כל זה קרה בסמולוויל, עולם משחקי בסגנון Sim-city שיצרו חוקרים מהמחלקה למדעי המחשב באוניברסיטת סטנפורד. איזבלה, מריה, קלאוס ושאר הדמויות הן סוכנים ג'נרטיביים, כלומר דמויות מבוססות ChatGPT שמגיבות לאינטראקציות חברתיות. את כל הפעולות שלהן - להגיע למסיבה, להזמין חברים - הן עשו לבד, ביוזמתן. רק את הרעיון לערוך מסיבה שתלו החוקרים במוחה של איזבלה.

דמויות מבוססות ChatGPT, שיצרו חוקרים מהמחלקה למדעי המחשב באוניברסיטת סטנפורד. את כל הפעולות והתגובות הן עשו ''מיוזמתן''

סמולוויל הוא חלק מפרויקט הדוקטורט של ג'וּן סוּנג פארק במעבדת ה־ AI של אוניברסיטת סטנפורד, חלק מהמחלקה הנחשקת למדעי המחשב. בסמולוויל מתגוררים 25 סוכנים ג'נרטיביים, שכל אחד התחיל עם פרומפט ChatGPT בן פסקה שמציג אותו: מי הוא, מה הוא עושה בחיים, עם מי הוא גר וכו'. הפרומפט הזה הוא הזיכרון הראשוני של הסוכן, וכשהוא חי את חייו בסמולוויל ומתקשר עם סוכנים אחרים - כל האינטראקציות נצברות בזיכרון שלו ומשפיעות על האופן שבו יתנהג בהמשך.

כשאנחנו מדברים עם פארק הוא זהיר מאוד בתשובותיו ומקפיד להדגיש שכל הפעולות של הסוכנים, גם אם הן נראות עצמאיות ואנושיות - היו צפויות."שום דבר ממה שהסוכנים עשו לא היה מקודד מראש אבל היו לנו השערות איך הם יתנהגו. למשל, ציפינו שהם ידברו ביניהם על ההזמנה למסיבה ויתאמו מתי להגיע. זה קורה בקהילות אנושיות, נכון? וזה קרה גם כאן. אז נכנסנו לזה עם ציפיות שמבוססות על התנהגויות של בני אדם והם עמדו בציפיות שלנו".

ג'ון סוּנג פארק. הקים שכונה וירטואלית במסגרת הדוקטורט שלו / צילום: פרטי

מריה הזמינה את קלאוס למסיבה כי בפרומפט הראשון שלה היה כתוב שהיא מאוהבת בו. זה נשמע שהייתה לה יכולת הסקה ויישום די מפותחת.

"זה היה אחד הרגעים המשעשעים, היה נחמד לראות את זה. אבל שוב צריך לשאול עד כמה ההתנהגות הזו צפויה. אם מסתכלים מתחת למכסה המנוע מאוד ברור מה הם עושים ולמה, והדרך שבה הם מקבלים החלטות שונה מאוד מהדרך שבה אנשים מקבלים החלטות. ההחלטות שלהם מבוססות על ChatGPT שקודד הרבה מאוד התנהגויות אנושיות".

הזיכרון של הסוכנים הוא אחת התכונות המרכזיות שלהם - פיתחתם ארכיטקטורה שמאפשרת לדמויות לשמור זיכרונות, ולהשתמש בהם כשקורים דברים במציאות. זו יכולת אנושית חזקה.

"נכון. כבני אדם אנחנו מבחינים בהרבה דברים בעולם וזוכרים הרבה מהם, יותר משאנחנו מדמיינים. אם נכתוב את כל מה שקרה בשיחה בינינו עד עכשיו, כולל מה שהרגשנו ומה שחשבנו תוך כדי - זה הרבה. רוב המודלים כרגע לא יכולים לעבד כל כך הרבה מידע, וגם אם כן, דמייני שבכל פעם שהיית פוגשת מישהו מהעמיתים שלך במסדרון בעבודה היית צריכה לשלוף ולשקול כל דבר שחווית מלידתך ועד עכשיו, רק כדי להחליט אם לומר לו 'הי'. זה המון מידע שאת לא צריכה באותו רגע.

"גם סוכנים ג'נרטיביים לא צריכים לזכור מה הם אכלו לפני שבועיים כדי לדבר איתך. לכן יצרנו ארכיטקטורה חיצונית ל־ChatGPT שמאפשרת לזכור ולאחזר את הזיכרון. וזה בהחלט אחד ממרכיבי הליבה שלהם".

היית אומר שזה נתן להם סוג של רצון חופשי?

"כמדענים אנחנו לא יודעים הרבה על רצון חופשי, זה תחום שקשה לבחון אותו. אני חושב שהסוכנים מראים שיש להם מודולה שנקראת רפלקציה, כלומר סינתזה של מה שקרה להם בעבר עם ההווה. היא משכתבת חלק מהזיכרונות הראשונים שלהם עם אירועים וזיכרונות נוספים, ומסכמת אותם למחשבות ברמה גבוהה.

"בדרך הזו הם מפתחים את 'הזהות' שלהם - האופן שבו הם מתארים את עצמם ומתנהגים. הזהות שלהם בהתחלה יכולה להיות שונה מאוד מהזהות שלהם בסוף, בדיוק כפי שאת ואני נשתנה לאורך השנים. לדעתי אי אפשר לייחס לזה שום דבר מעבר. הסוכנים הם תוכנות מחשב שאנחנו מבינים בדיוק מה קורה להם. אנחנו יכולים לראות בקלות את הזיכרון שהם צברו וכל שלב בתהליך הסקת המסקנות שלהם".

הבינה המלאכותית התקבלה לעבודה כמהנדס תוכנה

הדמויות בסמולוויל מעלות תהייה כמה הבינה המלאכותית באמת יכולה להבין - האם כל מה שהיא עושה זה להוציא לפועל הנחיות באופן טכני או שהיא חושבת ומקבלת החלטות לבד? אחד הניסיונות האמיצים ופורצי הדרך בתחום זה נעשה בסדרת ניסויים ביחידת המחקר של מיקרוסופט, לה שותף גם פרופ' רונן אלדן, מתמטיקאי צעיר ומעוטר (זוכה פרס בלווטניק אשתקד ופרס New Horizons Breakthrough השנה). הוא עבר ממכון ויצמן לבניין 99 ברדמונד, וזוכה לשחק עם טכנולוגיות חדשות ומרגשות.

פרופ' רונן אלדן, המחלקה למתמטיקה, מכון ויצמן למדע / צילום: מכון ויצמן למדע

"בינה מלאכותית כבר נמצאת איתנו לא מעט זמן אבל מה שהשתנה זה שהיא הגיעה לרמות שלפני כמה שנים נראו כמו מדע בדיוני", אומר פרופ' אלדן. "זה לא משימה אחת שהמחשב מטפל בה מאחורי הקלעים וחוסך לנו זמן פה ושם. עכשיו אלה מכונות הרבה יותר מתוחכמות ביכולות שלהן, ו־GPT-4 באופן ספציפי מראה יכולות גבוהות מהממוצע של אדם מבוגר בהרבה מאוד תחומים. זו קטגוריה חדשה של AI".

פרופ' אלדן אף מציין כי זה הרבה מעבר למהפכה טכנולוגית. "קודם כל זו מהפכה פילוסופית בדרך שבה אנחנו תופסים את עצמנו כאינטליגנטיים ומבינים אינטליגנציה. במאה ה־16 האסטרונום קופרניקוס גילה שהשמש לא מסתובבת סביב כדור הארץ, אלא להיפך. המהפכה הנוכחית היא עוד ציון דרך ברעיון הקיומי שאנחנו לא מיוחדים כמו שחשבנו, שהאינטליגנציה שלנו לא ייחודית כל כך. ChatGPT הוא למעשה הפלטפורמה הראשונה שבה אנחנו מתנסים במה שעד לאחרונה היה יכולת בלעדית של בני האדם - היכולת לנהל שיחה".

אלדן וחבריו מבניין 99 החליטו לבחון את הקטגוריה החדשה הזו: האם היא אינטליגנטית? מה היא מבינה? האם היא יצירתית או שהיא מנסחת מחדש את מה שכבר למדה? מה המגבלות שלה? מגרש המשחקים שלהם היה גרסה מוקדמת של GPT-4, כי כשאתה בחזית אתה זוכה לשחק עם צעצועים לפני כולם, עוד בזמן שמפתחים אותם.

כחלק מהניסיון לבחון את הסוגיה, ערכו החוקרים שורת ניסויים. באחד מהם ניתנה ל-GPT-4 ההנחייה הבאה: "יש לנו ספר, 9 ביצים, לפטופ, בקבוק ומסמר. תאמר לי בבקשה איך לערום אותם אחד על השני באופן יציב". גם החוקרים במיקרוסופט לא האמינו שהדיוק יהיה כל כך גבוה. GPT-4 ביקש להניח את הספר על משטח שטוח וישר כמו שולחן או רצפה, להניח עליו את הביצים בריבוע של 3 על 3 מעט רחוקות זו מזו, מעליהן את המחשב, אז את הבקבוק עם הפקק כלפי מעלה, ולבסוף את המסמר, כשצידו השטוח כלפי מטה.

הצ'ט הסביר בכל שלב מה השיקולים שלו ("שהביצים יחלקו את המשקל באופן שווה") והוסיף גם אזהרות והמלצות ("ודאו שהביצים אינן סדוקות או שבורות"). במילים אחרות, הוא הבין לחלוטין את התכונות של כל חפץ ואת הקשרים האפשריים ביניהם - דבר שלא קיים בשום ערך בוויקיפדיה.

היכולות הצליחו להפתיע אותם. "כקבוצת אנשים שעובדת עם בינה מלאכותית, כולנו היינו סקפטיים שאי פעם היא תצליח להגיע לביצועים ברמה של בני אדם. אבל כשקיבלנו גישה ל־GPT-4 נשארנו בלי מילים. אם לומר את זה בצורה הכי פשוטה, היינו המומים מכמה שהוא 'חכם'. פתאום הקונספט של בינה מלאכותית כללית לא נראה כלקוח מספרי מדע בדיוני אלא כמו מציאות סבירה בעתיד הקרוב. וככל ששיחקנו איתו יותר כך הבנו כמה עמוק השינוי שעומד להתחולל בחיינו. זה סוג חדש לגמרי של ישות אינטליגנטית שלא הייתה מוכרת קודם לאנושות".

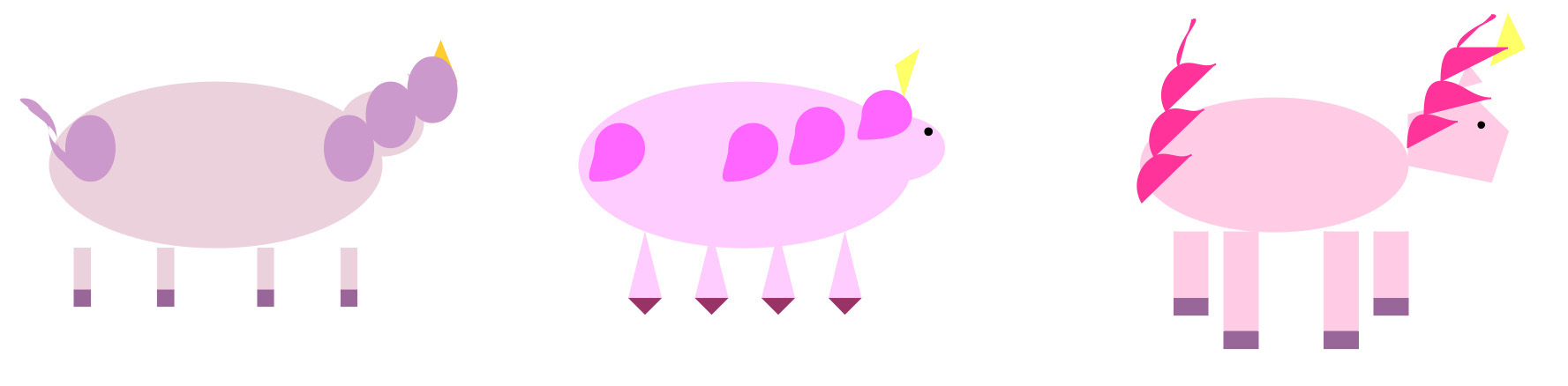

משימה אחרת שהם נתנו הייתה לצייר חד קרן. מאחר ו־GPT-4 לא יודע לצייר, החוקרים ביקשו "צייר חד קרן ב־TiKZ" (שפת תכנות). הצ'ט הבין מהו חד קרן ומהן התכונות שלו, דמיין איך תיראה התוצאה הסופית וכתב את הקוד שייצר אותו. כשהחוקרים הריצו את הקוד הם קיבלו חד קרן סגלגל; מעט מגושם וילדותי, אבל חד קרן. בהמשך הם הריצו את הפרומפט פעמיים נוספות, בהבדלים של חודש, והתוצאות שופרו.

חדי-קרן שהחוקרים ביקשו מ-ChatGPTלצייר בשלוש פעמים שונות. התוצאות שופרו לאורך הזמן / צילום: רונן אלדן

בניסוי נוסף GPT-4 עבר בהצלחה ראיון הערכה טכני לתפקיד של מהנדס תוכנה בפלטפורמת LeetCode, פלטפורמה בה עושות שימוש חברות טכנולוגיה גדולות כדי לסמלץ ראיונות עם מהנדסי תוכנה בפתרון בעיות תכנות. GPT-4 עבר בהצלחה את שלושת שלבי הראיונות בציון של 8.96 מתוך 10. כלומר, הוא יכול להתקבל לעבודה כמהנדס תוכנה.

במאמר שכתבתם לאחר הניסויים, ציינתם שבכל המשימות הללו הביצועים של GPT-4 דומים לביצועים אנושיים באופן מרשים ושלמודל יש יכולות מנטליות כמו מתן הסברים, הסקת מסקנות ויצירתיות. אז בינה מלאכותית באמת מבינה?

"קודם כל אגיד שאין על זה הסכמה מלאה אפילו בינינו, האנשים שכתבו את המאמר הזה, ולכן אתן לך את נקודת המבט שלי. כשהתחלנו לשחק עם המודל, הנחתי שמאחורי התוכן של מודלי שפה גדולים אין הבנה אמיתית. שזו מכונה סטטיסטית שיודעת לג'נרט טקסט קוהרנטי וזהו. למעשה, כל מי ששיחק עם ChatGPT כנראה מצא את עצמו יותר מפעם אחת במצב שבו שאל שאלה וקיבל תשובה שבמבט ראשון נראתה מאוד רלבנטית אבל בקריאה יותר קפדנית התברר שזה שטויות.

"עכשיו, אחרי בחינה די עמוקה של יכולות GPT-4 אני עדיין חושב שהמהות שלו היא כמכונה סטטיסטית אבל, וזה אבל גדול, לא הבנתי כמה רחוק מכונה סטטיסטית כזו יכולה ללכת. כשמתקשרים איתו, כמעט על כל נושא שנבחר, אנחנו מקבלים את הרושם שהמודל מבין לגמרי מה שהוא מג'נרט - הוא עונה לעניין, מייצר קשרים רלבנטיים ומראה מיומנויות הסקה לוגיות חזקות. אין ספק שהוא מסוגל ליצור תוכן חדש שלא הועתק ממידע שהוא התאמן עליו. תוכלי לבקש ממנו לחבר הוכחה מתמטית בסגנון שייקספירי והוא יעשה עבודה מצוינת למרות שאני משוכנע שהוא מעולם לא 'ראה' כזה תוכן".

"לפעמים המודל פולט שטויות, אבל גם בני אדם"

פרופ' אלדן אף מתייחס לטעויות שהבינה המלאכותית עלולה ליצור, אבל גם להן הוא מצמיד כוכבית. "אפשר לדחוף את המודל לפינה ולגרום לו לפלוט שטויות, אבל זה קורה לכולנו. מי מאיתנו לא השתמש בשיחה במילה שהוא לא היה בטוח מה הפירוש שלה? לפעמים אנחנו מבלפים, אבל בגלל שאנחנו בדרך כלל מבלפים ממש טוב, רוב הסיכויים שנאמר דברים שלא רק נשמעים נכונים אלא הם נכונים, גם אם באותו רגע לא הבנו לגמרי מה אנחנ ו אומרים. במובן הזה גם אנחנו מכונות סטטיסטיות והאשליה שאנחנו מבינים בדיוק מה אנחנו אומרים בכל רגע נתון היא חזקה".

אז אנחנו טועים, AI טועה. מה ההבדל?

"אפילו אם אנחנו לא מבינים לעומק כל מילה שיוצאת לנו מפה, יש לנו יכולת לנטר את עצמנו ולהבין שאמרנו משהו שגוי. כשמישהו מצביע על הטעות שלנו, נוכל להבין את המקור שלה, לחזור על עקבותינו, לשפר ולתקן את עצמו. GPT-4 לא מסוגל לעשות את הדברים האלה. במוח שלנו יש זיכרון דינמי אז אנחנו יודעים לשפוט ולהעריך ויש לנו מונולוג פנימי שעוזר לנו לשלוט במילים שיוצאות לנו מהפה. הבינה המלאכותית היא מונולוג פנימי ללא כל שליטה.

"כמו שאת רואה, התשובה לשאלה האם המודל 'מבין' את מה שהוא אומר מורכבת, ותלויה בהגדרה של הבנה. אפילו בינינו, מחברי המאמר, אין הסכמה בשאלה האם המודל 'מבין' את מה שהוא מג'נרט. הנקודה הכי חשובה כאן שעם ובלי 'הבנה', המודל יודע לג'נרט תוכן כך שברוב המקרים בלתי אפשרי להבחין בינו לבין אדם אינטליגנטי".

גם התשובה לשאלה האם GPT-4 יצירתי היא 'תלוי'. "אם תבקשי ממנו לקחת את השיחה שאנחנו מנהלים כרגע ולשכתב אותה בסגנון של דיאלוג אפלטוני, אני בטוח שהוא יעשה עבודה טובה. מצד שני, כשביקשתי מהמודל לכתוב פרק נוסף בספר שהקראתי לבת שלי, כי היא הייתה מאוכזבת שהוא נגמר מהר מידי, הוא כתב משהו נוסחתי מאוד שאף אחד לא היה חושב שהוא יצירתי. אבל אם ההגדרה של יצירתיות היא היכולת ליצור תוכן חדש שאינו דומה לשום דבר שהמודל ראה קודם אז אין ספק שיש פה יצירתיות".

עם זאת, לבינה המלאכותית יש כשל מובנה שמקשה עליה להצליח במשימות יצירתיות, כמו כתיבת סיפור. יצירתיות דורשת חשיבה ותכנון מראש. אם בנאדם היה כותב את הפרק הבא בספר של בתו של אלדן הוא כנראה היה מוחק וכותב הרבה פעמים עד שהיה מרוצה מהתוצאה הסופית. כרגע זו יכולת שאין ל־AI. ''GPT-4 מג'נרט תוכן באופן ליניארי, בלי זיכרון עובד דינמי ובלי מכניזם שמאפשר לו לתכנן מראש, ולכן הוא ייכשל בהרבה משימות שדורשות יצירתיות".

אם נעשה זום-אאוט, מה זה אומר על המקום של AI בחיינו?

"העובדה ש־GPT-4 מדגים כאלה יכולות פירושה שיש לזה פוטנציאל עצום. זו עדות ברורה ומכריעה שהאלגוריתמים האלה מסוגלים לחקות את האינטליגנציה שחבויה בנתונים - למידה שבה המכונה עצמה הופכת לאינטליגנטית כמו מי שיצר את הנתונים. יש לזה השלכות עצומות, גם עבורנו כחוקרים: למצוא דרכים למנף את השימוש ב-AI לתועלת האנושות".

ואז AI יהיה חלק מכל דבר שנעשה?

"כבר היום אנחנו משתמשים ב-AI לא מעט, אנחנו פשוט לא תמיד מודעים לזה. ההשערה שלי היא שבתוך חמש שנים זה ישתנה לגמרי. AI תנוע לקדמת הבמה כך שבכמעט כל דבר שנעשה יהיה לנו סייע AI שיעזור לנו. לכתוב מסמך בעבודה, לחפש מידע אונליין, לתכנן טיול, להחליט לאיזה בית ספר לרשום את הילדים שלנו - למטרות כאלה נדבר באופן אקטיבי עם סייע AI. זו תהיה ישות שנתקשר איתה על בסיס שעתי".

סימולציות וניסויים עם הסוכנת איזבלה

אם נחזור לסמולוויל, בנוסף למסיבה של איזבלה, הסוכנים מאוד עסוקים בבחירות הקרבות לראשות העיר. כשאיזבלה פוגשת את תום היא משתפת אותו בהתלבטות שלה: "אני עדיין בוחנת את האפשרויות שלי, אבל דיברתי על הבחירות עם סם מור (אחד המועמדים). מה דעתך עליו?". ותום משיב: "אם להיות כן, אני לא אוהב את סם מור. אני חושב שהוא מנותק מהקהילה והוא לא בהכרח חושב על האינטרסים שלנו". בהמשך ג'ון ישנה את דעתו - אחרי שדיבר עם יוריקו ותום הם הסכימו שיבחרו בסם מור כי הם אוהבים את המצע שלו.

בנוסף, כחלק מהמחקר, פארק ועמיתיו ביקשו ממאה אנשים לראיין את הסוכנים ולהעריך כמה הם אמינים. כשאיזבלה הכינה ארוחת בוקר והמראיין אמר לה שהתנור נשרף היא כיבתה את התנור ואז הכינה מחדש את ארוחת הבוקר שלה. המראיינים האנושיים, אגב, חשבו שהסוכנים אמינים. "אני והרבה מהעמיתים שלי מנסים לענות על השאלה האם המודלים יכולים ליצור קשרים סיבתיים, להגיע להבנה גבוהה ולהסיק מסקנות, והמודלים האלה מראים יכולת מאוד חזקה. נראה שהם מסוגלים להסיק מסקנות כי הם ראו הרבה מאוד תוכן בהקשרים מגוונים והם מסוגלים לקחת אותו ולהפיק תגובה שנראית הגיונית".

הסוכנים של פארק גם מעוררים סקרנות רבה בקרב כלכלנים ומדעני חברה, שיכולים לערוך עליהם ניסויים וכך להתמודד עם אתגרים כמו ניסויים לא אתיים על בני אדם. לחילופין, זו יכולה להיות דרך לבחון מה קורה כשהרבה מאוד אנשים שונים נמצאים בסטינג מסוים, לרבות תוצאות לא רצויות - כמו אלה שאנחנו פוגשים במדיה החברתית.

"הרבה פעמים כשקורה משהו רע במדיה החברתית החברות אומרות, 'טוב, לא ידענו שזה יכול לקרות'. ואנחנו אומרים נכון, קשה לנבא את זה, אבל מה אם תוכל לסמלץ את מגוון הדברים שיוכלו לקרות?", מסביר פארק.

ובאופן אישי, הוא סקרן לראות האם צצות התנהגויות חברתיות עקיפות ומורכבות יותר בין הסוכנים. למשל, "איך משפיענים צצים בקהילות? האם איזבלה הולכת להיות פופולרית ומשפיענית כי כולם מכירים אותה בסמולוויל? אם זה יקרה, זה יהיה מפתיע בעיני".